Synopsis

Im Projekt soll eine interaktive Musik-”Experience” in einer Virtual-Reality (VR)-Umgebung erstellt werden, die als Fallstudie zur nächsten Stufe in der Entwicklung des medialen Konzepts des Musik-"Videos" das volle Potenzial des digitalen Mediums ausnutzt. In einer solchen VR-Anwendung wird sich das Publikum inmitten des audiovisuellen Geschehens befinden und mit der Musik interagieren, die im Sinne einer auditiven Szenografie den dreidimensionalen Raum aufspannt. Das Projekt wird gefördert von der Gesellschaft Hamburg Innovation im Rahmen der Call4Transfer-Förderung 2020.

Beteiligte

Projektleitung

- HAW Tonlabor (Prof. T. Görne, Anca Tutescu )

- HfMT Multimedia Composition (Dr. K. Orlandatou, Jan Wegmann )

Projektpartner

- HAW GamesLab (Maik Helfrich , Artjom Fransen , Charly Preisig , Maria Weninger , Valentin Fischer )

Das Projekt wurde gefördert durch die Hamburg Innovation GmbH, welche wiederum durch die Stadt HH, Behörde für Wissenschaft, Forschung, Gleichstellung und Soziales gefördert wird.

Das Projektvolumen beläuft sich auf 29,500€.

Projektbeschreibung

Das immersive digitale Medium stellt technisch-gestalterische Möglichkeiten zur Verfügung die weit über das konventionelle Musikvideo hinausgehen und bislang in konventionellen Produktionen nicht genutzt werden. Das beantragte Projekt soll zur Vorbereitung eines Forschung-/Entwicklungsvorhabens dienen in dem diese Möglichkeiten umfassend thematisiert werden. Im Mittelpunkt des hier beantragten Projekts steht daher nicht nur die Auseinandersetzung mit der dreidimensionalen virtuellen Welt als Spielraum und mit den Möglichkeiten der multi-modalen Interaktion des Publikums mit den medialen Inhalten, sondern insbesondere auch die Auseinandersetzung mit der dreidimensionalen auditiven Szene als Aufführungsraum für Musik. Dabei sollen modernste technische Entwicklungen zum Einsatz kommen, die derzeit bereits in den beteiligten Laboren entwickelt und erprobt werden, insbesondere in Echtzeit binaural gerenderte auditive Szenen mit personalisierten Kopf-Übertragungsfunktionen (HRTF) und Headtracking.

Zudem soll mit Technologien wie Eye-Tracking und haptischem Feedback erforscht werden mit welchen Werkzeugen sich das immersive Erlebnis positiv steigern lässt und auf welche Weise User in das musikalisch-virtuelle Geschehen eingreifen können und wollen. In der Auseinandersetzung mit nichtlinearen Erzählweisen wird die Integration musikalischer Komponenten mit Spielmechaniken aus Videospielen erprobt.

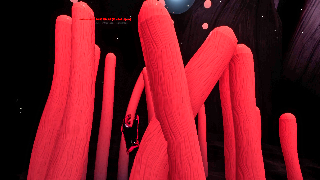

Eine wesentliche Frage der Ästhetik eines solchen Formats ist die Visualisierung der Musik, die Wahl der visuellen Ausdrucksform. Auch dies wird Gegenstand der Studie sein. Schon in der virtuellen Umgebung “Second Life” (2003), in der der User als Avatar in einer 3D-Modellierung einer digitalen Welt agiert, finden Musikkonzerte statt. Man kann in dieser Welt untertauchen und mit anderen Avatars ein gemeinsames soziales Erlebnis besuchen, dennoch ist der User nicht in der Lage z.B. mit einer Band live zu interagieren oder die Musik durch diese Interaktion zu manipulieren. Zwar existiert bereits eine Reihe von VR-Musikvideos (z.B. “FANTASYNTH”, ein statisches, abstraktes VR-Musikerlebnis für einen Track, oder “The Hills Remix feat. Eminem” von The Weeknd, ein 360°-Musikvideo). Doch die weitaus meisten solcher Beispiele nutzen weder die Möglichkeiten der Interaktion und nichtlinearen Erzählweise, noch das gestalterische Potenzial dreidimensionaler auditiver Szenografie, und bleiben damit Produktionen in der Tradition konventioneller Musikvideos mit “3D-Effekt”.

Auf künstlerischer Ebene sind sich die Bereiche Bildende Kunst, Klangkunst/Musik/Sound Design und Gaming im Kontext von VR sehr nah. Für visuelle und klangbasierte Kunst ist VR/AR ein neues und oft noch unentdecktes Gebiet. Es ermöglichen sich nicht nur visuell und auditiv neue Darstellungsmöglichkeiten im virtuellen 3D-Raum, auch die ebenfalls hier immanente Interaktivität (z.b. durch die Drehung der virtuellen Kamera mittels des eigenen Kopfs) lässt sich künstlerisch nutzen. Hier liegt die Schnittstelle zum Game Design, das eine interaktive Nutzung des virtuellen (3D-)Raums voraussetzt und diese kreativ nutzt.

Die Kooperation zwischen der HAW und HfMT soll die Zusammenarbeit zwischen Studierenden verschiedener Fachbereiche und Kompetenzen ermöglichen und verstärken, besonders in Fragestellungen der Audio-Spatialisierung, Synästhesie, Game Design, Immersion, Haptik und Musik, mit Ausgangspunkten in den bereits etablierten Projekten “Moving Sound Pictures” und “Kinetics in Sound & Space”; hier insbesondere im über 3,5 Jahre laufenden Teilprojekt “Untersuchungen zur Wahrnehmung und Ästhetik virtuell-räumlicher Klangszenen”.